-

タグ

タグ

- アーキテクト

- アジャイル開発

- アプリ開発

- インシデントレスポンス

- イベントレポート

- カスタマーストーリー

- カルチャー

- 官民学・業界連携

- 企業市民活動

- クラウド

- クラウドインテグレーション

- クラブ活動

- コーポレート

- 広報・マーケティング

- 攻撃者グループ

- 子育て、生活

- サイバー救急センター

- サイバー救急センターレポート

- サイバー攻撃

- サイバー犯罪

- サイバー・グリッド・ジャパン

- サプライチェーンリスク

- システム開発

- 趣味

- 障がい者採用

- 初心者向け

- 白浜シンポジウム

- 情シス向け

- 情報モラル

- 情報漏えい対策

- 人材開発・教育

- 診断30周年

- スレットインテリジェンス

- すごうで

- セキュリティ

- セキュリティ診断

- セキュリティ診断レポート

- 脆弱性

- 脆弱性管理

- ゼロトラスト

- 対談

- テレワーク

- データベース

- デジタルアイデンティティ

- 働き方改革

- 標的型攻撃

- プラス・セキュリティ人材

- モバイルアプリ

- ライター紹介

- ラックセキュリティアカデミー

- ランサムウェア

- リモートデスクトップ

- AI

- ASM

- CIS Controls

- CODE BLUE

- CTF

- CYBER GRID JOURNAL

- CYBER GRID VIEW

- DevSecOps

- DX

- EC

- EDR

- FalconNest

- IoT

- IR

- JSOC

- JSOC INSIGHT

- LAC Security Insight

- OWASP

- SASE

- Tech Crawling

- XDR

クラウドサービス部の内海です。

オンプレミス環境で稼働するVMware vSphere基盤をクラウドへ移行する動きが増加しています。そこで、社内にあるオンプレミスのVMware vSphere環境を利用して、VMware HCX(以下、HCX)を用いた移行や、L2延伸について前後編で解説します。前編ではHCX Connectorのインストールと初期セットアップまでをご覧いただきました。

後編の今回は、HCX Managerへの接続やL2延伸と移行について説明します。

環境構築作業

HCX Connectorのインストールと初期セットアップまでの前編の作業に続き、オンプレミスのHCX ConnectorとOCVSのHCX Managerのピアリングを進めていきます。

オンプレミスのHCX ConnectorとOCVSのHCX Managerのピアリング

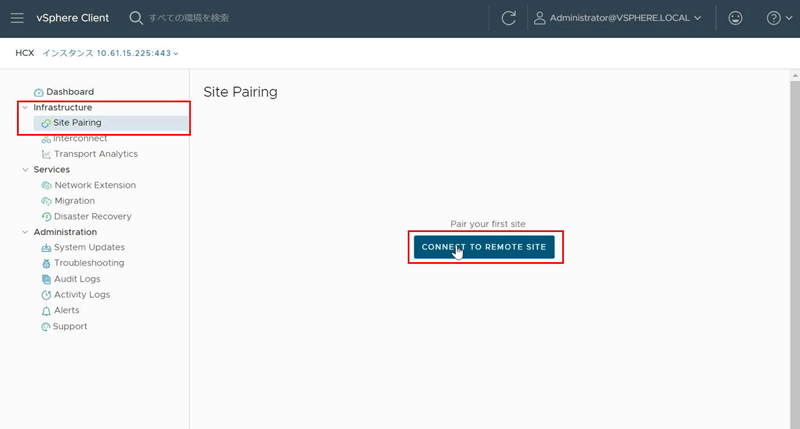

前回初期セットアップを行ったHCX Connectorにログインし、サイトピアリングを行います。vCenter Serverにログインし、左上ハンバーガーメニューの「HCX」をクリックして、HCX Connectorのダッシュボード画面にアクセスします。左側のメニュー「Infrastructure」の「Site Pairing」、続いて画面中心の「CONNECT TO REMOTE SITE」の順にクリックします。

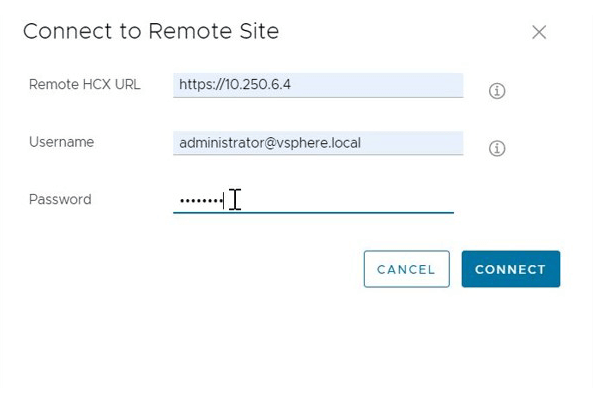

「Connect to Remote Site」のポップアップが表示されたら、以下の通りに入力して「CONNECT」をクリックします。なお、「CONNECT」をクリックした後、「Certificate Warning」という証明書の警告が表示され、証明書のインポートを促される場合があります。これが表示されたら、「IMPORT CERTIFICATE」を選択してください。

| 項目名 | 入力内容 |

|---|---|

| Remote HCX URL | OCVSのコンソール画面から確認したHCX ManagerのIPアドレスの頭にhttps://をつけて入力します。 |

| Username | OCVS側のHCX Managerのユーザ名を入力します。初期設定から変えていなければvCenter ServerのSSOとなるため、administrator@vshpere.localとなります。 |

| Password | OCVS側のHCX Managerのパスワードを入力します。初期設定から変えていなければ、OCIコンソールの「VMwareソリューション」の「ソフトウェア定義のデータ・センターの詳細」画面から確認可能です。 |

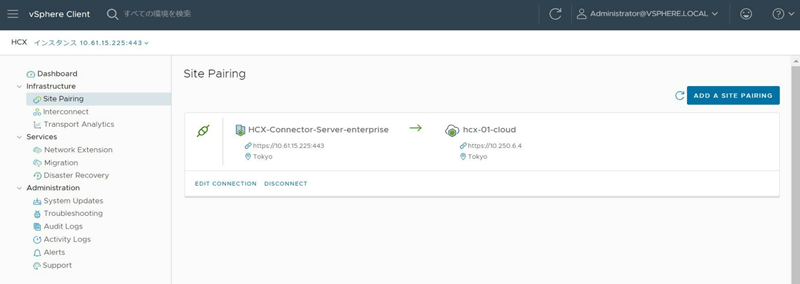

上手くいけば、以下画像の通り、「Site Pairing」画面でオンプレミスのHCX Connector情報と、OCVSのHCX Manager情報が表示されます。

HCXの移行準備

次は、HCXの移行を行うために必要な以下3つの作業を行います。

- ネットワークプロファイルの設定

- コンピュートプロファイルの設定

- サービスメッシュの作成

なお、これらの作業は全てオンプレミス側にあるHCX Connectorで実施すればよく、OCVS側のHCX Manager側で作業する必要はありません。

ネットワークプロファイルの設定

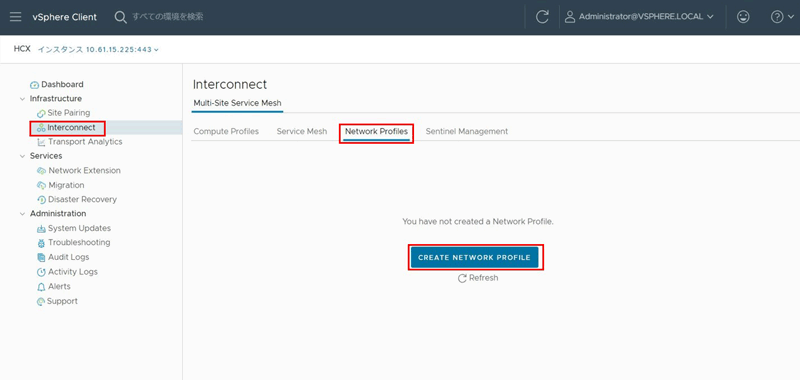

まずは、HCXの移行に必要な各種ネットワークのプロファイルを作ります。HCX Connector画面の左側メニュー「Infrastructure」から「Interconnect」をクリックし、画面上部タブで「Network Profiles」を選択したら、画面中心の「CREATE NETWORK PROFILE」をクリックします。

ネットワークプロファイルは、以下の4つを作成する必要があります。それぞれが、前編で作成した分散ポートグループの4つに対応します。

| 項目名 | 内容 |

|---|---|

| Management Network | HCX Manager、vCenter Server、DNS等の管理システムとの通信に利用するネットワーク。 |

| Uplink Network | HCX InterConnect(以下、HCX-IX)アプライアンスが相手側サイトのHCX-IXとの通信に利用するネットワーク。 |

| vMotion Network | vMotionに利用するネットワーク。HCX vMotion Migrationで利用。 |

| vSphere Replication Network | Sphere Replicationに利用するネットワーク。HCX Bulk Migrationで利用。 |

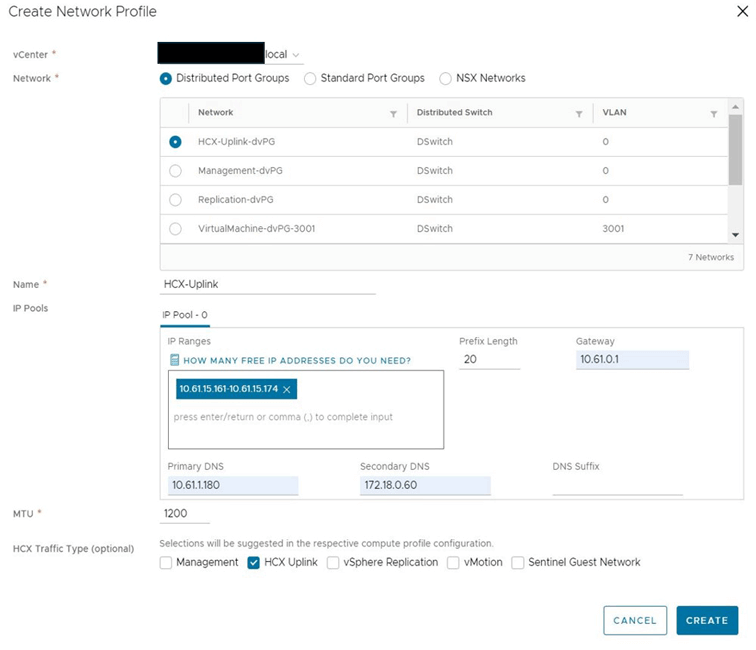

プロファイルの作成順序に決まりはありませんが、ここではUplink Networkに該当するものを最初に作成します。「Create Network Profile」ポップアップで表示される各項目を、以下の通り設定していきます。

| 項目名 | 入力/操作内容 |

|---|---|

| vCenter | オンプレミス側vCenter ServerのFQDNを入力します。 |

| Network | Distributed Port Groups <前編で作成したHCXアップリンクネットワーク用のポートグループを選択> (ここでは「HCX-Uplink-dvPG」) |

| Name | 任意のプロファイル名を記載します。 |

| IP Pools - IP Ranges | ここで指定したIPアドレス範囲から、HCX-IX等のコンポーネントのNICにIPアドレスが割り振りされます。IPアドレスがいくつ必要かわからない場合は、「HOW MANY FREE IP ADDRESSES DO YO NEED?」をクリックすると、構成に応じて必要なIPアドレス数を自動算出してくれます。 |

| IP Pools - その他項目 | プレフィックス長やデフォルトゲートウェイ、DNSサーバのIPアドレスをオンプレミスネットワーク環境に応じて記入します。 |

| MTU | 任意のMTUを入力します。HCXユーザガイド(Version4.8)においては、各移行方式における最小MTUは1150以上とされています。本環境では拠点間接続にサイト間VPNを利用しているため、HCXとサイト間VPNによる二重のIPsecカプセル化を考慮し、MTUを1200と小さめに設定しています。 |

| HCX Traffic Type | 作成したいプロファイル種別に応じて選択します。最初にHCX Uplinkの作成をするので、HCX Uplinkを選択します。 |

一通り入力し終えたら「CREATE」をクリックします。同様に、Management Network、vMotion Network、vSphere Replication Networkの3つのネットワークプロファイルも作成しておきます。

コンピュートプロファイルの設定

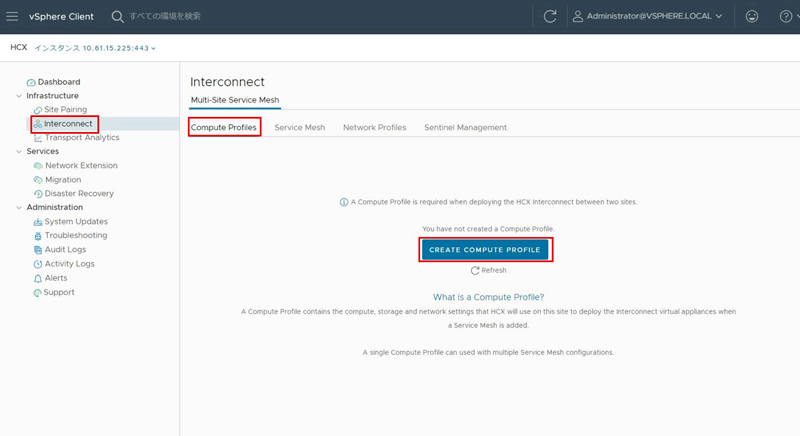

次にコンピュートプロファイルの作成をします。ここで、有効化するHCX機能やデプロイ先となるクラスタ、利用するネットワークプロファイル等の設定を含むプロファイルを作成します。HCX Connector画面の左側のメニュー「Infrastructure」の「Interconnect」をクリックし、画面上部タブから「Compute Profiles」を選択してから、画面中心の「CREATE COMPUTE PROFILE」をクリックします。

「Create Compute Profile」ポップアップで表示される各項目を、以下の通り設定します。

| 項目名 | 入力/操作内容 |

|---|---|

| Name your Compute Profile | 任意のコンピュートプロファイル名を入力します。 |

| Select Services to be activated | 利用したい機能にチェックします。単純にvMotion MigrationやBulk Migrationに利用するだけであれば、以下にチェックをすれば大丈夫です。

|

| Select Service Resources | HCXアプライアンス群をデプロイするクラスタを選択します。なお、ESXiホストを指定してデプロイすることはできないので注意してください。 |

| Select Deployment Resources and Reservations | 利用するデータストアとフォルダを選択します。また、必要に応じてCPUとメモリの予約を行います。なお、CPUとメモリの予約は0%でも移行可能です。予約した場合、予約した分のリソースが確保できないとサービスメッシュの作成時に失敗します。 |

| Select ●● Network Profile | 該当のネットワークプロファイルに該当するものを選択します。先ほど作成したネットワークプロファイルを選択します。 |

| Select Network Containers Eligible for Network Extension | L2延伸を行いたいネットワークを持つ分散仮想スイッチを選択します。 |

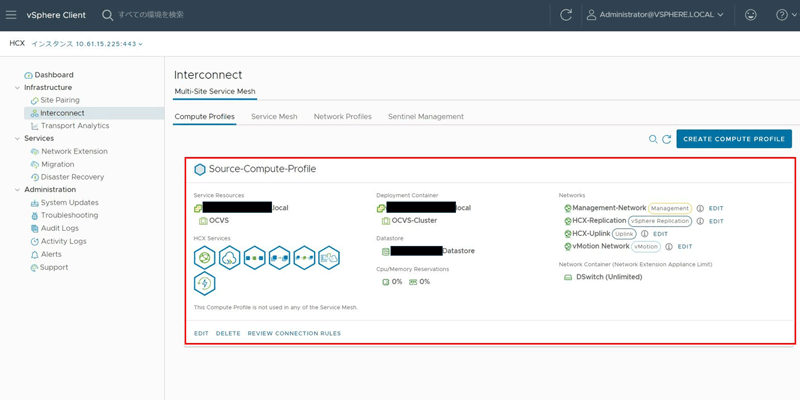

一通り入力したら、「FINISH」をクリックします。以下の通り、作成したCompute Profileが表示されていることを確認します。

なお、上記画像ではHCXサービスとしてReplication Assisted vMotion MigrationとDisaster Recoveryも有効化します。そのため、前表に記載のHCXサービスだけを有効化した場合、HCX Servicesのアイコンの表示が画像と異なりますが、後続の手順への影響はありません。

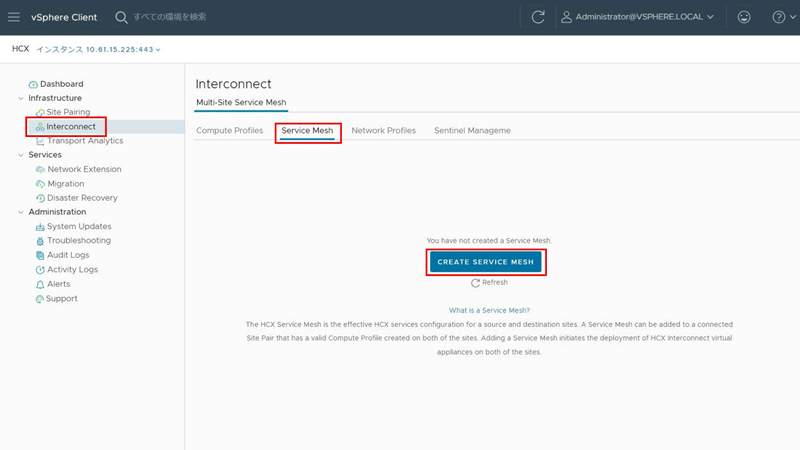

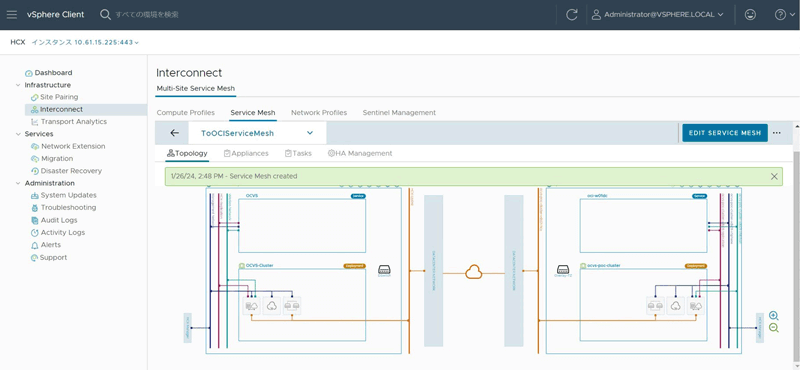

サービスメッシュの作成

次にサービスメッシュを作成します。このタイミングでHCX-IXやHCX-Network Extension(以下、HCX-NE)等のHCXアプライアンス群が作成されます。HCX Connectorの画面の左側のメニュー「Infrastructure」の「Interconnect」をクリックし、画面上部タブから「Service Mesh」を選択して、画面中心の「CREATE SERVICE MESH」をクリックします。

「Create Service Mesh」ポップアップで表示される各項目を、以下の通り設定します。

| 項目名 | 入力/操作内容 |

|---|---|

| Select Sites | 接続元のHCX Connectorと接続先のHCX Managerを選択します。 |

| Select Compute Profile | 接続元と接続先のコンピュートプロファイルを選択します。 |

| Select Services to be activated | コンピュートプロファイル作成時に選択したものと同様のサービスが選択されていることを確認します。なお、ここでグレーアウトになっているサービスがある場合、どちらかのサイトのコンピュートプロファイルにおいて有効化されていない可能性があります。 |

| Advanced Configuration - Override Uplink Network profiles (Optional) | 先ほど作成したHCX Uplink Networkプロファイルを変更・上書きしない場合は設定不要です。 |

| Advanced Configuration - Network Extension Appliance Scale Out | HCX-NEを冗長化したい場合にはAppliance Countを2以上に設定します。 |

| Advanced Configuration - Traffic Engineering | 帯域制御やTCPセグメントサイズの調整等、ネットワークパフォーマンスに関する調整をしたいときに設定します。単なる検証目的であればデフォルト値で問題ありません。 |

| Ready to Complete - Provide a user friendly name for this Service Mesh | 任意のサービスメッシュの名前を入力します。 |

一通り入力したら、「FINISH」をクリックします。しばらく時間を置いた後、以下の通り、作成したService Meshが表示されていることを確認します。

ここまでで、移行に必要な準備は完了です。この後で行うL2延伸作成は、OCVS移行後にIPアドレスを変えたくない場合に必要な作業です。

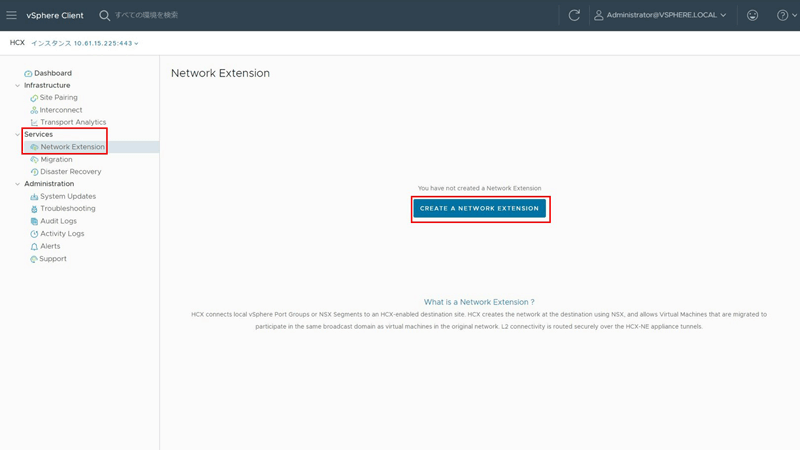

L2延伸作成

ここまでの作業で、HCXの移行は可能です。ただし、「オンプレミスVMware環境にあるVMのIPアドレスを変更せずにOCVSに移行したい」という要件がある場合、これから説明するNetwork Extensionを作成することで、オンプレミス側のネットワークをOCVS側にL2延伸し、IPアドレスを変更せずに移行できるようになります。

HCX Connector画面の左側のメニュー「Services」の「Network Extension」を選択し、画面中心の「CREATE A NETWORK EXTENSION」をクリックします。

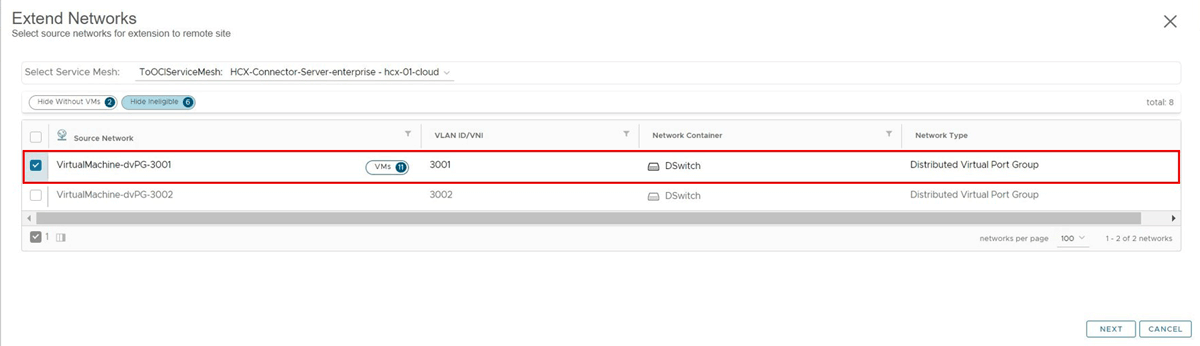

移行対象のネットワークを選択し、「NEXT」をクリックします。

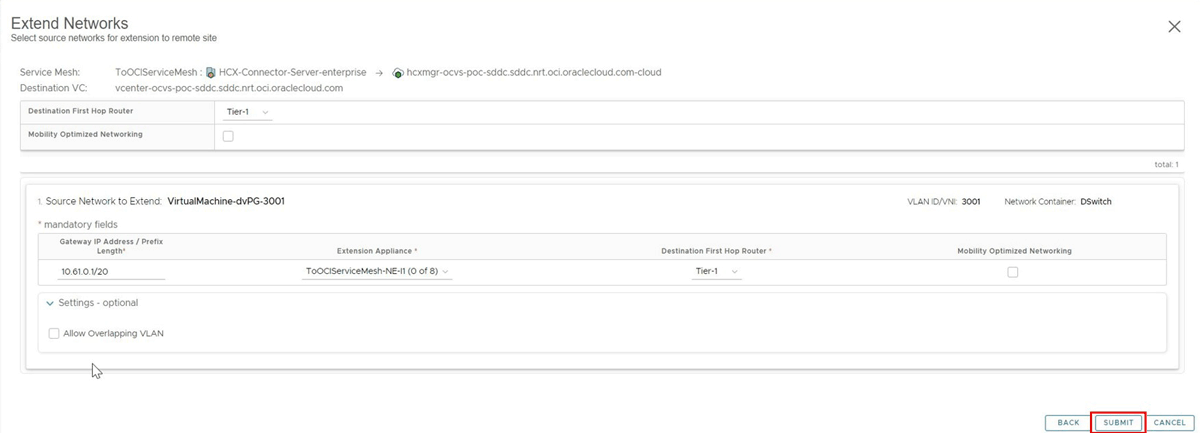

次の画面では宛先ファーストホップルータやデフォルトゲートウェイの設定変更、Mobility Optimized Networking(MON)機能の有効化を行えますが、今回はデフォルトのまま「SUBMIT」をクリックします。

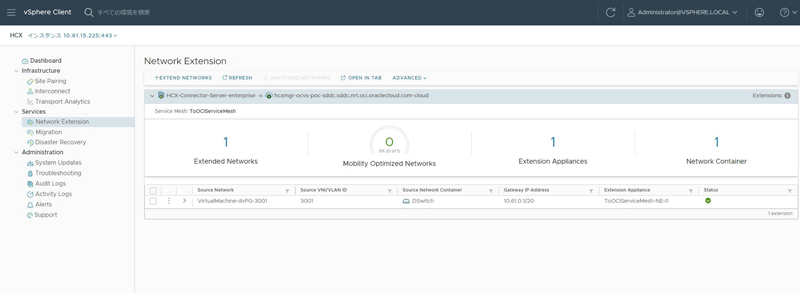

少し時間を置いて、問題なくNetwork Extensionが作成されていることを確認します。

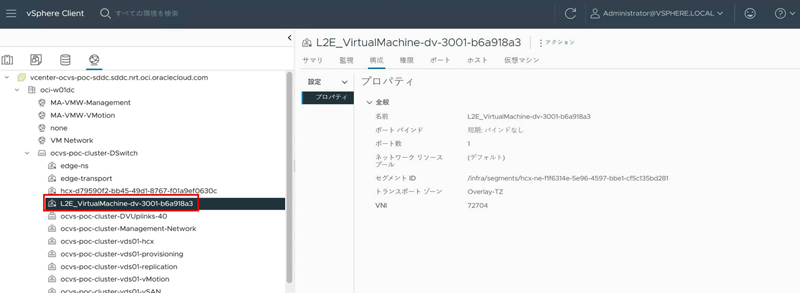

OCVS側のvCenter Serverにログインすると、先ほど作成したL2延伸対象のネットワークがNSX-Tセグメントとして作成されていることが確認できます。

移行実施

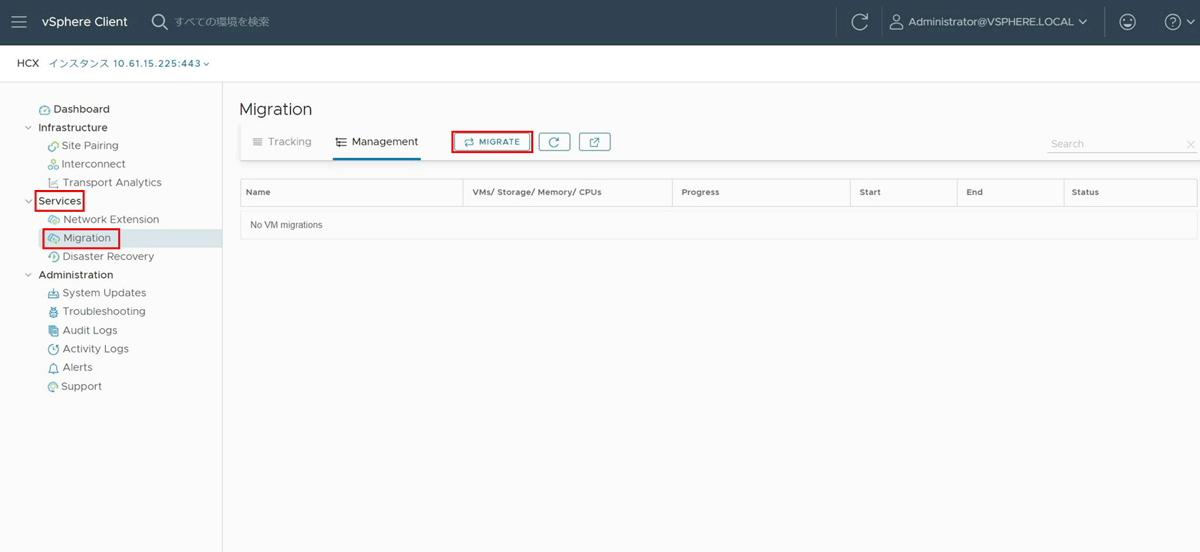

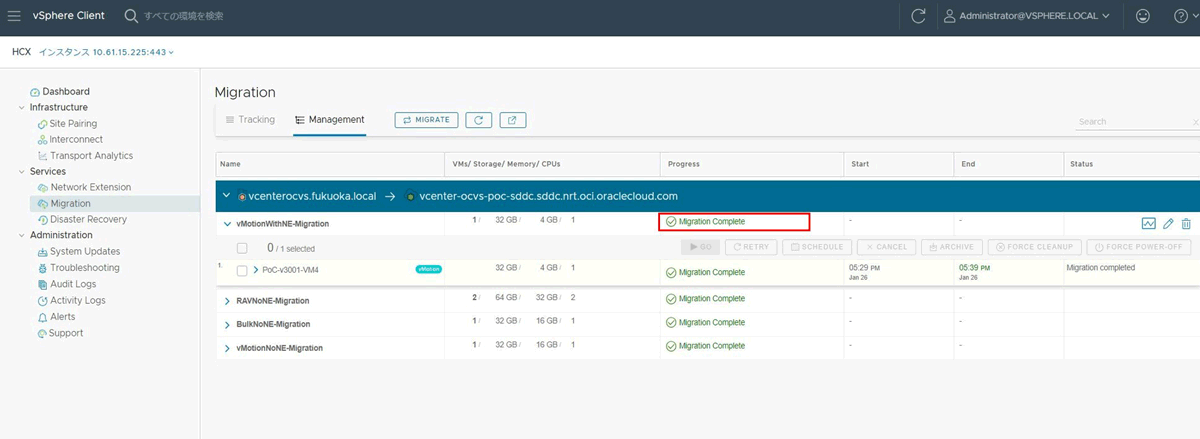

これで準備が整ったので、HCXによるvMotion移行を行います。HCX Connector画面の左側のメニュー「Services」の「Migration」をクリックし、画面上部タブから「Management」を選択してから、「MIGRATE」ボタンをクリックします。

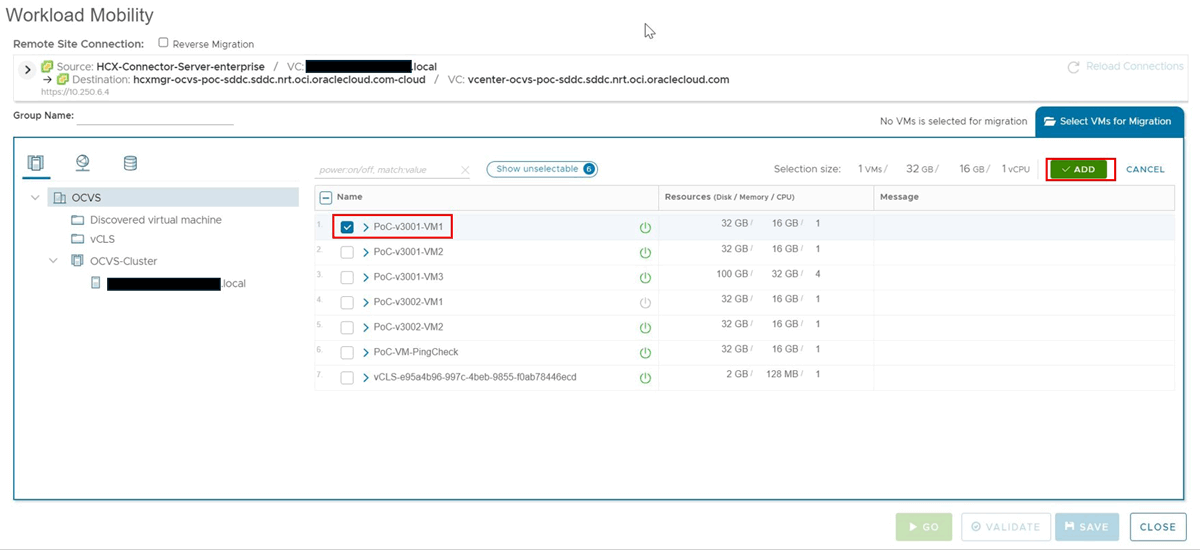

「Workload Mobility」のポップアップが開いたら、移行対象のVMにチェックを入れ、「ADD」をクリックします。

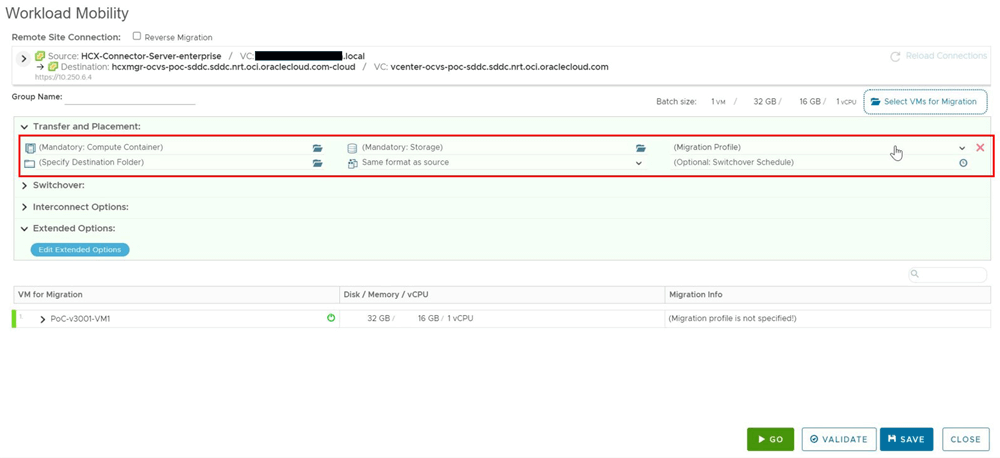

次の画面で移行に関する各種設定を入力します。まずは赤枠の「Transfer and Placement」を設定します。

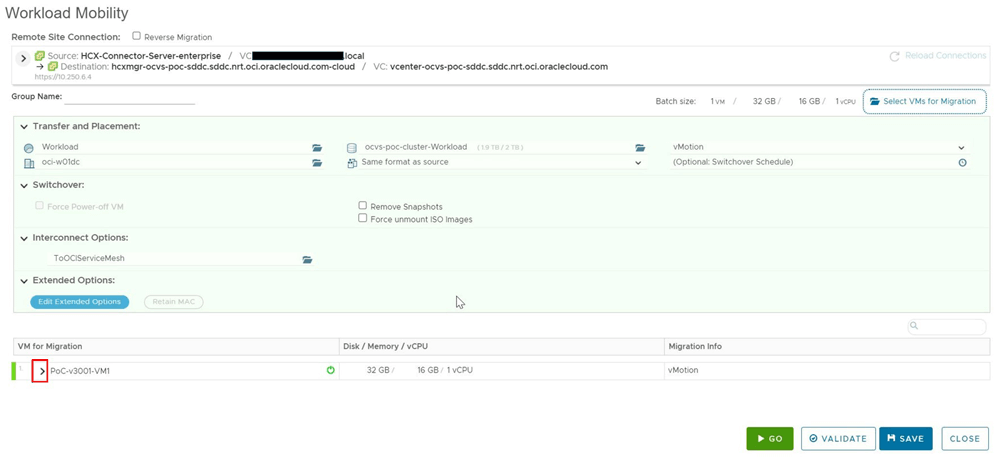

設定項目は以下の表を参考にしてください。

| 項目名 | 入力/操作内容 |

|---|---|

| (Mandatory: Compute Container) | OCVS側のクラスタの「Resources」配下の「Workload」を選択します。 |

| (Mandatory: Storage) | OCVS構築時に作成された、データストア用のブロック・ボリュームを選択します。 |

| (Migration Profile) | vMotionを選択します。 |

| (Specify Destination Folder) | 任意のフォルダを選択します。 |

| (Mandatory: Virtual Disk Format) | 任意のディスクフォーマットを選択します。今回の例ではSame format as sourceを選択しています。 |

| (Optional: Switchover Schedule) | 移行のスイッチオーバーをするタイミングを時間指定したい場合は時間で指定します。スケジューリングせず、即時実行する場合は、時計アイコンを押下して表示されたポップアップ内の「Ignore failover window and start migration as soon as possible」にチェックを入れます。 |

なお、「Switchover」「Interconnect Options」「Extended Options」は必要に応じ指定できますが、今回は特に利用したい設定は無いため割愛します。

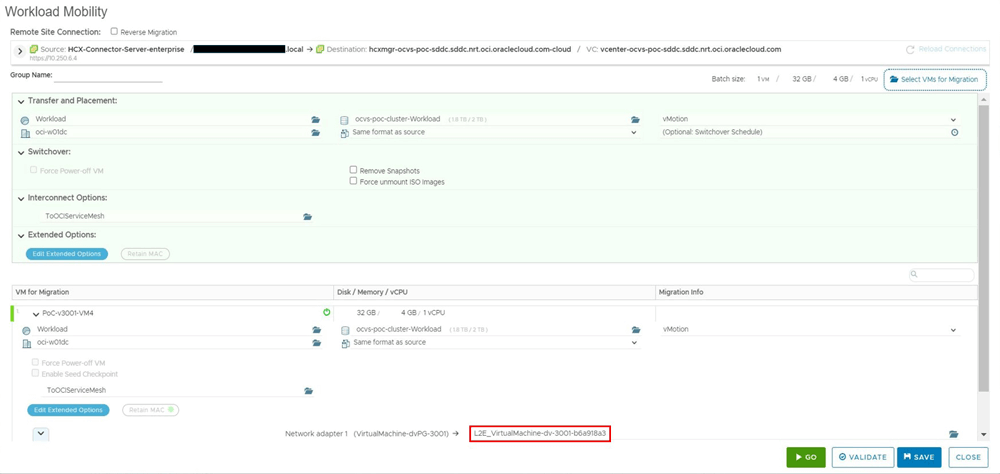

「Transfer and Placement」を入力し終えたら、次は画面下部の「VM for Migration」で移行対象VM名の左にある「>」ボタンをクリックします。

開かれたオプション部分に、移行先ネットワークを選択する項目があるので、先ほど「L2延伸作成」の作業で作成したネットワーク名を指定します。

ここまで入力したら準備完了です。画面右下の「▶GO」をクリックして移行を実行します。

しばらく時間をおいて、「Progress」が「Migration Complete」になっていることを確認したら移行完了です。

検証の所感

以下は、今回のHCXの検証を通しての所感です。

幅広いスキルや知識が必要

オンプレミスからOCVSへの移行にHCXを利用する際は、VMwareの知識に加え、VLANやL2延伸をはじめとするネットワークの知識も不可欠です。いずれかが欠けると、トラブルや効率低下に繋がりかねません。実際の移行では、VMwareとネットワーク双方の有識者を含めた体制で行うのが良いと感じました。

事前の構成、制約の確認を終えれば設定作業は意外とスムーズ

最初にHCXについてVMware公式HCX User GuideやWebサイトで調べ始めたときは、前提条件や制約が多く、手順も複雑そうに見えたため、非常にハードルが高い作業に思えました。しかし、少しずつ情報を整理していくと、事前に必要な構成を整え、制約を理解しておけば、設定作業そのものは比較的短期間で終えられることがわかりました。

VMwareやネットワークの知識を活かし、しっかりドキュメントを読み込んで使いこなせば、vMotion、Bulk Migrationといったユースケースに合わせた移行ができる、非常に強力なツールといえます。

おわりに

オンプレミスのVMware基盤をOCVSに移行するには、今回ご紹介したHCXをはじめ、前提となるOCI/OCVS基盤の構築、オンプレミスとOCI間のネットワーク接続(サイト間VPN/FastConnect)、さらにL2延伸と幅広い知識が求められます。そのため、十分な知見が無い状態で行うのはかなりハードルが高いでしょう。

ラックではOCVSの導入支援サービスを提供しています。お客様のVMware環境をヒアリングし、「OCI/OCVSに移行できるか?」「移行するには何をすれば良いか?」「どの程度コストがかかるか?」といった疑問にお答えします。無償での簡易アセスメントも行っていますので、ぜひお気軽にご相談ください。また、OCVSについてより詳しく知りたい場合は、以下のリンクからホワイトペーパー「Oracle Cloud VMware Solution導入支援サービスによる移行の勧め」をダウンロードできますので、ぜひご活用ください。

ラックではOCIだけでなく、AWS、Azure、Google Cloudにも対応しており、お客様のシステム環境の課題に合わせた最適な提案をします。マルチクラウドやハイブリッドクラウドも含めたシステム構成に関するお悩みがございましたら、ぜひラックまでお問い合わせください。

プロフィール

内海 賢

クラウド/サーバ/ネットワークを主軸に各種案件に入り、システム構築/保守運用/技術検証などを行っています。技術面の手を動かすところから人との調整まで楽しんで働いています。IPA SC/NW、AWS SAP/DOP、PMP他資格複数所持。

タグ

- アーキテクト

- アジャイル開発

- アプリ開発

- インシデントレスポンス

- イベントレポート

- カスタマーストーリー

- カルチャー

- 官民学・業界連携

- 企業市民活動

- クラウド

- クラウドインテグレーション

- クラブ活動

- コーポレート

- 広報・マーケティング

- 攻撃者グループ

- もっと見る +

- 子育て、生活

- サイバー救急センター

- サイバー救急センターレポート

- サイバー攻撃

- サイバー犯罪

- サイバー・グリッド・ジャパン

- サプライチェーンリスク

- システム開発

- 趣味

- 障がい者採用

- 初心者向け

- 白浜シンポジウム

- 情シス向け

- 情報モラル

- 情報漏えい対策

- 人材開発・教育

- 診断30周年

- スレットインテリジェンス

- すごうで

- セキュリティ

- セキュリティ診断

- セキュリティ診断レポート

- 脆弱性

- 脆弱性管理

- ゼロトラスト

- 対談

- テレワーク

- データベース

- デジタルアイデンティティ

- 働き方改革

- 標的型攻撃

- プラス・セキュリティ人材

- モバイルアプリ

- ライター紹介

- ラックセキュリティアカデミー

- ランサムウェア

- リモートデスクトップ

- AI

- ASM

- CIS Controls

- CODE BLUE

- CTF

- CYBER GRID JOURNAL

- CYBER GRID VIEW

- DevSecOps

- DX

- EC

- EDR

- FalconNest

- IoT

- IR

- JSOC

- JSOC INSIGHT

- LAC Security Insight

- OWASP

- SASE

- Tech Crawling

- XDR